6月23日 · 2019年

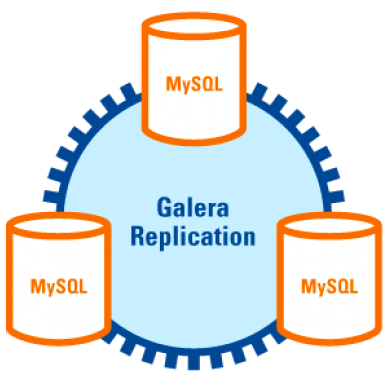

Docker镜像分享:一键部署MariaDB Galera Cluster集群

7702 37 29

3月16日 · 2019年

解决MySQL主从复制错误1595:Relay log write failure…

7078 9 11

9月20日 · 2018年

MySQL主从报错解决:Table ‘mysql.gtid_slave_pos’ doesn’t exist

2309 4 4

3月23日 · 2018年

MySQL在线DDL修改表结构的简单经验分享

6633 16 7

3月23日 · 2018年

gh-ost:在线DDL修改MySQL表结构工具

4774 4 3

2月5日 · 2017年

MySQL命令行工具:percona-toolkit安装使用初探

1477 19 34

7月31日 · 2016年

MySQL主从、字典死锁、连接数的Python监控脚本

1267 19 27

5月17日 · 2016年

MySQL错误修复记录:Table xx is marked as crashed and should be repaired

1200 11 32

3月29日 · 2016年

MySQL主从报错解决:Failed to initialize the master info structure

1451 6 9

1月17日 · 2015年

MySQL错误修复:Table xx is marked as crashed and last (automatic?) repair failed

1569 22 47

10月14日 · 2014年

单机MySQL数据库优化推荐的编译安装参数

2953 2 9

9月28日 · 2014年

Linux系统下MongoDB的简单安装与基本操作

1038 5 1