7月31日 · 2014年

VPS服务器备份网站文件和数据库到七牛云存储的shell脚本工具

4751 1 33

7月21日 · 2014年

nginx日志切割及7天前的历史日志删除脚本

7653 16 16

6月26日 · 2014年

Linux操作系统DNS解析(nameserver)监控脚本

7855 6 20

6月19日 · 2014年

[不定期更新]简单的shell脚本练习实例

1500 162 24

5月26日 · 2014年

js获取url中?后的参数,修复移动版无法切换到电脑版的BUG

4474 3 18

5月16日 · 2014年

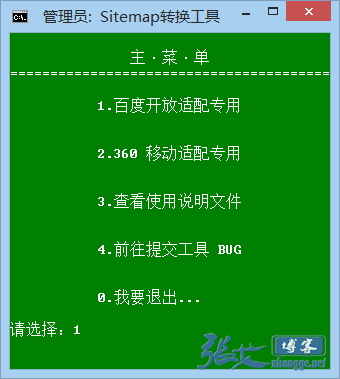

百度开放适配&360移动适配专用Sitemap格式转换工具

8537 13 52

3月4日 · 2014年

Ghost安装Win7/XP后自动恢复IP的批处理

4709 9 41

2月26日 · 2014年

菜单式Shell运维脚本调试小记

3672 10 6

2月19日 · 2014年

Shell脚本的简单排错法及调试程序bashdb

9315 20 32

1月10日 · 2014年

Win平台Web访问白名单设置脚本(IP安全性原则)

3852 0 0

12月30日 · 2013年

Windows下获取网络连线实际名称,加强IP类设置脚本的兼容性

3520 5 1

12月27日 · 2013年

Tomcat重启脚本For Windows

7312 19 4