最近在学习 K8S,其中会用到分布式文件存储系统,因此着手搭建测试了一把。为了简单方便,这里依然是基于 Docker 部署,极大地简化了部署配置的难度。

一、环境准备

文中涉及的 IP 的角色属性清单:

在 3 台服务器进行如下初始化:

1、配置 hosts

cat >> /etc/hosts <<EOF 192.168.1.100 ceph1 192.168.1.101 ceph2 192.168.1.102 ceph3 EOF

2、建立信任关系

#在 192.168.1.100(ceph1)上执行: ssh-keygen ssh-copy-id ceph2 ssh-copy-id ceph3

3、磁盘初始化

Ps:本文实验服务器环境有 11 块盘,实际部署时请根据服务器实际情况对下文代码进行调整。

①、格式化

ceph 推荐使用 XFS 格式,这里服务器有 11 块盘(/dev/sdb~/dev/sdl,不含系统盘),这里循环格式化(格式化之前注意有没有重要数据!):

for i in b c d e f g h i j k l;do mkfs.xfs -f /dev/sd${i}1; done

②、磁盘挂载

为每块磁盘 创建一个挂载点文件夹(/data1~/data11):

mkdir -p /data{1..11}

在/etc/fstab 追加如下内容:

cat >> /etc/fstab <<EOF /dev/sdb1 /data1 xfs defaults 0 0 /dev/sdc1 /data2 xfs defaults 0 0 /dev/sdd1 /data3 xfs defaults 0 0 /dev/sde1 /data4 xfs defaults 0 0 /dev/sdf1 /data5 xfs defaults 0 0 /dev/sdg1 /data6 xfs defaults 0 0 /dev/sdh1 /data7 xfs defaults 0 0 /dev/sdi1 /data8 xfs defaults 0 0 /dev/sdj1 /data9 xfs defaults 0 0 /dev/sdk1 /data10 xfs defaults 0 0 /dev/sdl1 /data11 xfs defaults 0 0 EOF

最后执行 mount -a 挂载,使用 df -h 查看挂载情况:

/dev/sdb1 1.9T 221M 1.9T 1% /data1 /dev/sdc1 1.9T 213M 1.9T 1% /data2 /dev/sdd1 1.9T 209M 1.9T 1% /data3 /dev/sde1 1.9T 221M 1.9T 1% /data4 /dev/sdf1 1.9T 213M 1.9T 1% /data5 /dev/sdg1 1.9T 213M 1.9T 1% /data6 /dev/sdh1 1.9T 213M 1.9T 1% /data7 /dev/sdi1 1.9T 213M 1.9T 1% /data8 /dev/sdj1 1.9T 214M 1.9T 1% /data9 /dev/sdk1 1.9T 214M 1.9T 1% /data10 /dev/sdl1 1.9T 226M 1.9T 1% /data11

4、安装 docker

可自行搞定,也可以如下使用 yum 安装:

yum install -y docker systemctl enable docker systemctl start docker

5、拉取 ceph 镜像

这里用到了 dockerhub 上最流行的 ceph/daemon 镜像:

docker pull ceph/daemon:latest

6、创建目录

mkdir /data/ceph/{admin,etc,lib,logs}

chown -R 167:167 /data/ceph/ #docker 内用户 id 是 167,这里进行授权

7、内核优化

#调整内核参数 cat >> /etc/sysctl.conf << EOF kernel.pid_max=4194303 vm.swappiness = 0 EOF sysctl -p # read_ahead, 通过数据预读并且记载到随机访问内存方式提高磁盘读操作,根据一些 Ceph 的公开分享,8192 是比较理想的值 echo "8192" > /sys/block/sda/queue/read_ahead_kb # I/O Scheduler,关于 I/O Scheculder 的调整,简单说 SSD 要用 noop,SATA/SAS 使用 deadline。 echo "deadline" > /sys/block/sd[x]/queue/scheduler echo "noop" > /sys/block/sd[x]/queue/scheduler

8、其他配置

把容器内的 ceph 命令 alias 到本地,方便使用,其他 ceph 相关命令也可以参考添加:

echo 'alias ceph="docker exec mon ceph"' >> /etc/profile source /etc/profile

三、部署 ceph

Ps:以下操作均在 192.168.1.100(ceph1)上进行。

1、编写脚本

vim /data/ceph/admin/start_mon.sh

#!/bin/bash

docker run -d --net=host \

--name=mon \

--restart=always \

-v /etc/localtime:/etc/localtime \

-v /data/ceph/etc:/etc/ceph \

-v /data/ceph/lib:/var/lib/ceph \

-v /data/ceph/logs:/var/log/ceph \

-e MON_IP=192.168.1.100,192.168.1.101,192.168.1.102 \

-e CEPH_PUBLIC_NETWORK=192.168.1.0/24 \

ceph/daemon:latest mon

Ps:Monitor 节点这里有个很关键的配置:MON_IP 和 CEPH_PUBLIC_NETWORK 要写全,比如本文有 3 台服务器,那么 MAN_IP 需要写上 3 个 IP,而且如果 IP 跨网段,那么 CEPH_PUBLIC_NETWORK 必须写上所有网段,否则就会像网上大部分已有教程一样,只指定一个 IP 和一个网段是无法启动的!

vim /data/ceph/admin/start_osd.sh

#!/bin/bash

# 这里表示有 11 个分区,及从 data1-data11,请根据实际情况修改:

for i in {1..11};do

docker ps | grep -w osd_data${i} && continue

docker ps -a | grep -w osd_data${i} && docker rm -f osd_data${i}

docker run -d \

--name=osd_data${i} \

--net=host \

--restart=always \

--privileged=true \

--pid=host \

-v /etc/localtime:/etc/localtime \

-v /data/ceph/etc:/etc/ceph \

-v /data/ceph/lib:/var/lib/ceph \

-v /data/ceph/logs:/var/log/ceph \

-v /data${i}/osd:/var/lib/ceph/osd \

ceph/deamon:latest osd_directory

done

vim /data/ceph/admin/start_mds.sh

#!/bin/bash

docker run -d \

--net=host \

--name=mds \

--restart=always \

--privileged=true \

-v /etc/localtime:/etc/localtime \

-v /data/ceph/etc:/etc/ceph \

-v /data/ceph/lib/:/var/lib/ceph/ \

-v /data/ceph/logs/:/var/log/ceph/ \

-e CEPHFS_CREATE=0 \ #0 表示不自动创建文件系统(推荐),1 表示自动创建

-e CEPHFS_METADATA_POOL_PG=512 \

-e CEPHFS_DATA_POOL_PG=512 \

ceph/daemon:latest mds

vim /data/ceph/admin/start_mgr.sh

#!/bin/bash

docker run -d --net=host \

--name=mgr \

--restart=always \

--privileged=true \

-v /etc/localtime:/etc/localtime \

-v /data/ceph/etc:/etc/ceph \

-v /data/ceph/lib:/var/lib/ceph \

-v /data/ceph/logs:/var/log/ceph \

ceph/daemon:latest mgr

vim /data/ceph/admin/start_rgw.sh

#!/bin/bash

docker run -d \

--net=host \

--name=rgw \

--restart=always \

--privileged=true \

-v /etc/localtime:/etc/localtime \

-v /data/ceph/etc:/etc/ceph \

-v /data/ceph/lib:/var/lib/ceph \

-v /data/ceph/logs:/var/log/ceph \

ceph/daemon:latest rgw

vim /data/ceph/admin/start_rdb.sh

#!/bin/bash

docker run -d \

--net=host \

--name=rbd \

--restart=always \

--privileged=true \

-v /etc/localtime:/etc/localtime \

-v /data/ceph/etc:/etc/ceph \

-v /data/ceph/lib:/var/lib/ceph \

-v /data/ceph/logs:/var/log/ceph \

ceph/daemon:latest rbd_mirror

2、启动 mon

①、在 192.168.1.100(ceph1)上运行 start_mon.sh,成功启动后会生成配置数据。接着 ceph 主配置文件,在追加如下内容:

cat >>/data/ceph/etc/ceph.conf <<EOF # 容忍更多的时钟误差 mon clock drift allowed = 2 mon clock drift warn backoff = 30 # 允许删除 pool mon_allow_pool_delete = true [mgr] # 开启 WEB 仪表盘 mgr modules = dashboard EOF

②、拷贝所有数据(已包含脚本)到另外 2 台服务器:

scp -r /data/ceph ceph2:/data/ scp -r /data/ceph ceph3:/data/

③、通过远程 ssh,在 ceph2 和 ceph3 上依次启动 mon:

ssh ceph2 bash /data/ceph/admin/start_mon.sh ssh ceph3 bash /data/ceph/admin/start_mon.sh

④、查看集群状态 ceph -s

如果能够看到 ceph2 和 ceph3 则表示集群创建成功,此时应该是 HEALTH_WARN 状态,因为还没有创建 osd。

2、启动 OSD

虽然 ceph/daemon 这个 docker 镜像支持一个镜像来启动多个 osd,映射到多块分区,但是为了方便管理,我们需要为每一块磁盘创建一个 osd。

在 3 台服务器上依次执行 start_osd.sh 脚本:

bash /data/ceph/admin/start_osd.sh ssh ceph2 bash /data/ceph/admin/start_osd.sh ssh ceph3 bash /data/ceph/admin/start_osd.sh

全部 osd 都启动后,稍等片刻后执行 ceph -s 查看状态,应该可以看到多了如下信息(总共 33 块盘,33 个 OSD 节点):

osd: 33 osds: 33 up, 33 in (33 个 osd,启动 33,注册 33)

3、启动 MDS

bash /data/ceph/admin/start_osd.sh ssh ceph2 bash /data/ceph/admin/start_osd.sh ssh ceph2 bash /data/ceph/admin/start_osd.sh

4、创建文件系统

# 创建 data pool ceph osd pool create cephfs_data 512 512 # 创建 metadata pool ceph osd pool create cephfs_metadata 512 512 # 创建 cephfs ceph fs new iyuwnei cephfs_metadata cephfs_data # 查看信息 ceph fs ls name: iyunwei, metadata pool: cephfs_metadata, data pools: [cephfs_data ]

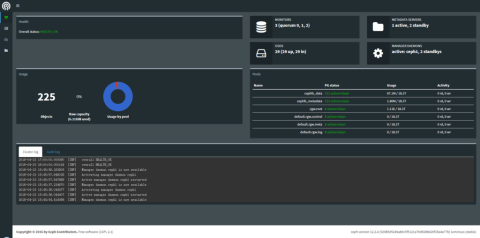

5、启动 MGR

MGR 是 ceph 自带的仪表盘监控,可以在一台服务器上单点启动也可以多点启动实现多活:

bash /data/ceph/admin/start_mgr.sh ssh ceph2 bash /data/ceph/admin/start_mgr.sh ssh ceph3 bash /data/ceph/admin/start_mgr.sh

启动后,在 ceph1 节点上执行如下命令激活仪表盘:

ceph mgr module enable dashboard ceph config-key put mgr/dashboard/server_addr 0.0.0.0 ceph config-key put mgr/dashboard/server_port 7000 #指定为 7000 端口,这里可以自定义修改

启动成功后,通过浏览器访问 http://192.168.1.100:7000 即可看到如下仪表盘:

Ps:如果这里使用多节点 mgr,可以在前面套一层 nginx 代理即可。关于更多 mgr 的配置可以参考的官方文档:http://docs.ceph.com/docs/master/mgr/dashboardhttps://ceph.com/planet/ceph-luminous-%E6%96%B0%E5%8A%9F%E8%83%BD%E4%B9%8B%E5%86%85%E7%BD%AEdashboard/

6、启动其他组件

①、启动 RGW

bash /data/ceph/admin/start_rgw.sh ssh ceph1 bash /data/ceph/admin/start_rgw.sh ssh ceph2 bash /data/ceph/admin/start_rgw.sh

②、启动 RBD

bash /data/ceph/admin/start_rbd.sh ssh ceph1 bash /data/ceph/admin/start_rbd.sh ssh ceph2 bash /data/ceph/admin/start_rbd.sh

7、最终状态

①、docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES b301b60b362f ceph/daemon:latest "/entrypoint.sh rgw" 2 weeks ago Up 2 weeks rgw 15fea1a996bd ceph/daemon:latest "/entrypoint.sh mgr" 2 weeks ago Up 2 weeks mgr 00896fe89924 ceph/daemon:latest "/entrypoint.sh rbd_m" 2 weeks ago Up 2 weeks rbd d5e9430a6ea1 ceph/daemon:latest "/entrypoint.sh mds" 2 weeks ago Up 2 weeks mds 05fc2ee09c42 ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data11 9de8cc2728cf ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data10 fc0263931fa8 ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data9 05eb72085c60 ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data8 ec94192d0be4 ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data7 506d7b5ee6bb ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data6 6e1a2c0ecccc ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data5 0d62f76624e8 ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data4 c60a502b8b5f ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data3 693b52b8a60d ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data2 1e776d7df07a ceph/daemon:latest "/entrypoint.sh osd_d" 2 weeks ago Up 2 weeks osd_data1 bdc22da7de73 ceph/daemon:latest "/entrypoint.sh mon" 2 weeks ago Up 2 weeks mon

②、ceph -s

cluster:

id: 843ea71c-786d-4c6e-b19d-9c20c47982e8

health: HEALTH_OK

services:

mon: 3 daemons, quorum ceph1,ceph3,ceph2

mgr: ceph1(active), standbys: ceph2, ceph3

mds: iyunwei-1/1/1 up {0=ceph1=up:active}, 2 up:standby

osd: 33 osds: 33 up, 33 in

rbd-mirror: 3 daemons active

rgw: 3 daemons active

data:

pools: 6 pools, 1056 pgs

objects: 2361 objects, 3213 MB

usage: 10288 MB used, 61439 GB / 61449 GB avail

pgs: 1056 active+clean

io:

client: 170 B/s rd, 2299 B/s wr, 0 op/s rd, 1 op/s wr

③、ceph mon dump

dumped monmap epoch 3 epoch 3 fsid 843ea71c-786d-4c6e-b19d-9c20c47982e8 last_changed 2018-04-23 14:38:34.095243 created 2018-04-23 14:35:59.641766 0: 192.168.1.100:6789/0 mon.ceph1 1: 192.168.1.101:6789/0 mon.ceph2 2: 192.168.1.102:6789/0 mon.ceph3

四、cephfs 挂载

ceph 目前支持对象存储(RGW)、块存储 RDB 以及 CephFS 文件系统这 3 种功能。本文主要记录 ceph 部署,所以这里仅测试下 CephFS 的简单挂载,对其他 2 种感兴趣的同学可以自行测试。

1、网络策略

如果公司内部有网络策略限制(比如我这边),那么先要保证挂载的客户端到 OSD 端口是畅通的。其中,每一个 OSD 都会启动一个端口,从 6789 一次递增,即第一个 OSD 是 6789,第二个则是 6790。

2、安装 ceph-fuse

由于本文使用的最新版的 ceph,而公司内部 yum 源能支持的 ceph-fuse 版本太低,会导致挂载卡死不成功问题。所以这里推荐使用官方最新 rpm 包安装:

yum install -y libibverbs gperftools-libs rpm -Uvh ceph-fuse-12.2.4-0.el7.x86_64.rpm

Ps:更多版本下载地址:http://mirrors.aliyun.com/ceph/rpm-luminous/el7/x86_64/

3、查看 ceph id 和 key

这里图简单,就不再创建新用户,直接使用已有的 admin 用户,所以我们要在 ceph 节点上查看 admin 的密钥:

①、ID

上文中的 ceph -s 或 ceph mon dump 信息中都有 ceph 的 ID 信息,即:

843ea71c-786d-4c6e-b19d-9c20c47982e8

②、KEY

cat etc/ceph.client.admin.keyring

[client.admin]

key = AQDOft1a7JulLhAABGhKyP/v/RfeRvfWHWOwoA==

auid = 0

caps mds = "allow"

caps mgr = "allow *"

caps mon = "allow *"

caps osd = "allow *"

4、创建配置文件

根据上述拿到的 ID 和 KEY,如下创建配置文件:

mkdir /data/ceph cat >> /data/ceph/cephfs.conf <<EOF [global] fsid = 843ea71c-786d-4c6e-b19d-9c20c47982e8 mon_host = 192.168.1.100,192.168.1.101,192.168.1.102 [client] client_mountpoint = / EOF cat >> cephfs.keyring <<EOF [client.admin] key = AQDOft1a7JulLhAABGhKyP/v/RfeRvfWHWOwoA== EOF

5、启动挂载

test -d /mnt/ceph_ext || mkdir /mnt/ceph_ext ceph-fuse /mnt/ceph_ext -n client.admin -k /data/ceph/cephfs.keyring -c /data/ceph/cephfs.conf

6、测试读写速度

这里用 dd 简单测试下,数值仅供参考。

# 测试写入 [root@localhost:/mnt/ceph_ext/backup]# cd /mnt/ceph_ext [root@localhost:/mnt/ceph_ext/backup]# dd if=/dev/zero of=test bs=1M count=1000 1000+0 records in 1000+0 records out 1048576000 bytes (1.0 GB) copied, 5.15503 s, 203 MB/s # 测试读取 [root@localhost:/mnt/ceph_ext/backup]# cd /mnt/ceph_ext [root@localhost:/mnt/ceph_ext/backup]# dd if=test of=test2 bs=1M count=1000 1000+0 records in 1000+0 records out 1048576000 bytes (1.0 GB) copied, 8.69913 s, 121 MB/s # 测试读写 [root@localhost:/mnt/ceph_ext/backup]# cd /mnt/ceph_ext [root@localhost:/mnt/ceph_ext/backup]# dd if=test of=test2 bs=1M count=1000 1000+0 records in 1000+0 records out 1048576000 bytes (1.0 GB) copied, 5.43514 s, 193 MB/s

学习了,沙发我就先坐着啦

怎么改黄体字了,输入留言还感觉不稳定一震一震的

docker 是一个神器

分布式文件存储系统,对于中大型系统,很必要的 :grin:

我就试一下

openstack+ceph也不错

大名鼎鼎的张哥博客。

博主网站的优化做得很不错,想换一个链接,行吗?

老铁最近更新频率太低了! :grin:

我加你qq了你不回复我,我遇到不能同步到新浪博客的问题 :sad: :sad: :sad:

看不懂不丢人吧?看不懂,不过支持博主!

请问您博客这些1环境准备是怎么编辑的?

博主这研究有点深入哦

大佬能做友联嘛~ 互相学习~

OSD为什么要是奇数?不是MON是奇数吗?

之前偶数个OSD的时候,health是黄色的,提示是osd数量要是奇数。有空我再核对下。

我目前就是5个节点,接了36个OSD,没提示health不正常。

好的,多谢提醒,我改下文章说明~

有幸访问到贵站,特此留下足迹,日后会经常来访!

不错。学习了.

我提示:

monmaptool: invalid ip:port '192.168.242.131,192.168.242.132,192.168.242.133:6789'

怎么回事啊

解决了吗?我也遇到了